更新时间:2019年08月05日 16066浏览

数据中心行业中对于400G网络的关注度正在快速上升,与此同时,让许多传统数据中心的用户非常困惑的是:部分传统数据中心的的主干才刚刚从10G/40G升到100G,难道真的有必要上400G吗?

2010年以来,不同类型的数据中心的的需求呈现分化的趋势,需求的层次是多样化的,用户选择不同带宽的应用是基于业务类型作出的理性的选择。笔者认为当前对于以下几种场景对于数据中心400G应用有相对比较迫切的需求。

超大规模数据中心

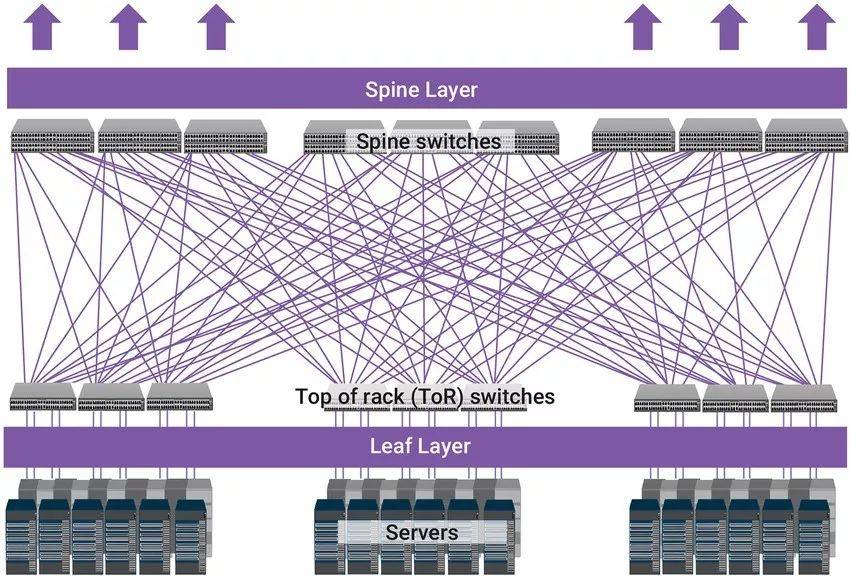

超大规模数据中心采用扁平的二层叶-脊(Leaf-Spine)架构需要大量的互连,因为每个Leaf与Spine完全互连,最大限度地实现交换机之间的无阻塞网络连接。数据中心的硬件加速器、人工智能和深度学习功能都消耗高带宽,迫使高端数据中心快速转向以更高数据速率运行的下一代互连。

400G在超大规模数中心的网络叶-脊架构互连应用将具有重要意义,相比较大量100G的互连,采用400G的接口不仅可以实现网络架构的简化,同时也可以降低同等速率应用的成本与单位流量的功耗,超大规模数据中心特别是叶-脊架构的网络对400G具有现实意义与迫切性。

数据中心互连DCI

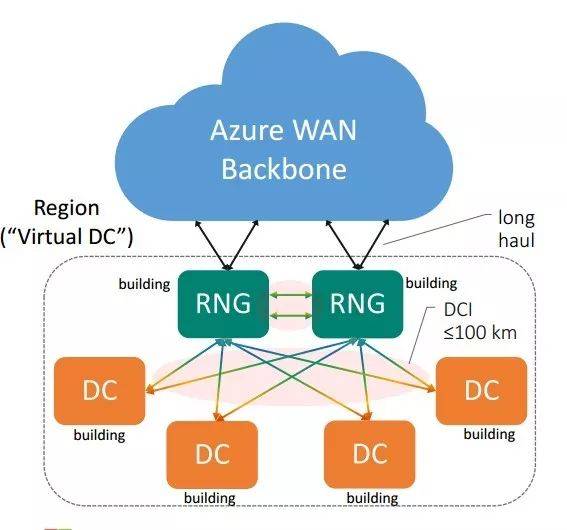

伴随着数据流量的爆炸性增长,数据中心网络逐步走向IP互联网的中心位置。目前的数据中心早已不再局限于一座或几座机房,而是一组数据中心集群,为实现网络业务的正常工作,要求这些数据中心协同运转,相互之间有海量的信息需要及时交互,这就产生了DCI网络需求。

云业务从根本上改变了计算模型和流量模型,网络流向从传统意义上的南北流量,转变成了IDC到IDC之间或者资源池之间的横向流量,数据中心间横向流量的占比正在逐步提升,这就要求数据中心互联网络必须具备大容量、无阻塞和低时延的特征,带宽成为DCI建设的首要焦点。

对于大型数据中心,为了地理上靠近客户,提供更好的服务体验,或者是数据中心之间互为灾备,这些数据中心可能分布于同一个园区内,或者同一个城市的不同的区域,甚至分布于不同的城市,通常这些数据中心之间距离在500m到80km范围内。

芯片到芯片及芯片到模块的连接

芯片对芯片(C2C)和芯片对模块(C2M)是最简单的互连形式,芯片到芯片的电气接口位于同一PCB平面上的两个IC之间,而芯片到模块的接口位于端口ASIC和具有信号调节IC的模块设备之间。IEEE802.3已经定义了连接单元接口(AUI),该接口基于不同类型光学模块的每通道50GB/s电气。根据互连长度和吞吐量要求,网络实施者可以选择不同的芯片到模块接口连接到光学模块。

硅光子技术是芯片与芯片互连推动力之一。硅光子技术是基于硅和硅基衬底材料(如 SiGe/Si、SOI 等),利用现有CMOS 工艺进行光器件开发和集成的新一代技术,结合了集成电路技术的超大规模、超高精度制造的特性和光子技术超高速率、超低功耗的优势,是应对摩尔定律失效的颠覆性技术。

硅光子产业发展规划,产业已经进入快速发展期,对比当前状态,硅光子技术在每秒峰值速度、能耗、成本方面分别能提高8倍、降低85%、降低 84%。硅光子以传播速度快和功耗低的特点成为超级计算市场的重要研究方向。

随着数据中心的核心网络设备间的传输速率的不断升高,自400G的应用开始,在芯片在芯片(C2C)以及芯片到模块间的应用自400G,800G甚至1.6T等更高速的传输中优秀的技术特性与商业价值将会更多地显现出来。